數據中心網絡特征- IT網絡運維

2020-05-05 18:33 作者:艾銻無限 瀏覽量:

對于我們IT網絡運維來說,新一代云計算數據中心是一個高密度,大容量的網絡應用場合,所以對網絡的帶寬、端口密度、安全防護、管理等各方面都提出了嚴峻的考驗。比如基于云計算應用的數據中心流量再也不像傳統數據中心只是有簡單的匯聚型流量,相對固定的交互流量,而是呈現高度的不定向突發性,傳統城域網交換機的性能難以滿足;比如數據中心設備高密度擺放,傳統城域網交換機橫插板的左右風道設計因此不能滿足綠色節能的要求等等。作為我們網絡運維必須了解這些新的架構。新的應用趨勢要求新一代數據中心的網絡應具有如下關鍵特征。

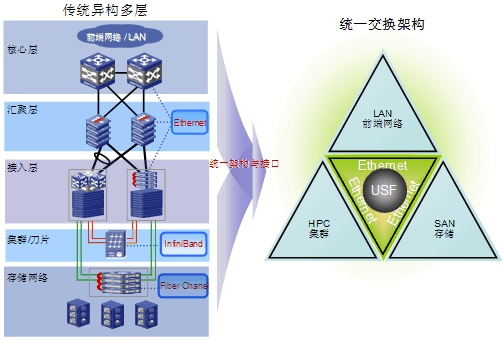

統一交換

新一代云計算數據中心將存在計算網、存儲網、業務網三張網,如果按原來建網方式,將可能會建設三張采用Infiniband、Fiber Chanel、Ethernet不同技術的網絡,其不僅大大增加建設與維護成本,而且技術異構的網絡將無法實現統一的虛擬化,從而難以實現真正意義上的云計算。幸運的是,隨著以太網技術的發展以及整個產業鏈的成熟,Ethernet已經可以取代甚至超越Infiniband、Fiber Chanel網絡,我們可以采用基于Ethernet的統一交換網來建設新一代數據中心,從而構建真正的云計算平臺。

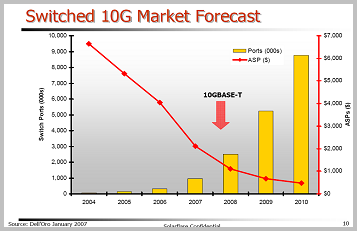

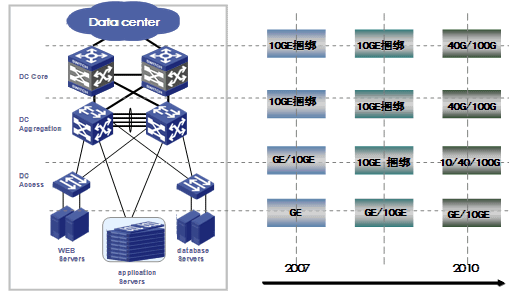

萬兆端口密度

從服務器數量上看,數據中心呈現一個明顯的發展規律———萬臺服務器規模的數據中心將是發展主流。同時,隨著單臺服務器集成的計算核數量的增長,其消耗的帶寬也同步增長,而10GE網卡采的硬件加速技術(TCP offload, iSCSI offload, RDMA acceleration)使服務器的吞吐能力接近線速。Gartner及Dell’Oro預測2006-2010年10GE交換端口的年增長率超過100%。

40G/100G接口支持能力

現在相當多的數據中心出口帶寬已達到100G以上,并且還在以每年50%-400%的速度增長。如果采用傳統的10G接口,則要用16-40個端口捆綁才能滿足未來一至兩年的需求。采用如此多的端口進行捆綁不僅消耗了大量寶貴的光纖資源,而且大大增加了管理維護的工作量。隨著40G/100G標準的最終定稿,可以預見一場40G/100G接口的普及風暴很快就會到來。

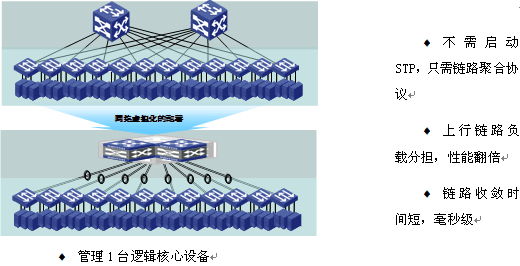

云計算不僅僅需要服務器與存儲實現虛擬化,網絡同樣需要與時俱進,能實現虛擬化。虛擬化的網絡不僅可以實現網絡資源的動態調配,在線擴充,簡化網絡配置與管理,而且可以大大提高數據中心網絡的可靠性。

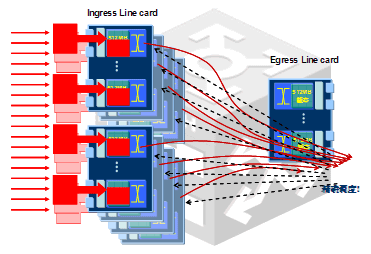

由于不同時刻各服務器上分布的應用都是動態調配的,而且服務器與服務器之間自動交互的頻繁度也將比現在獨立的應用時要高得多,所以云計算環境下的流量特征將比現在的多媒體流量環境下更為復雜、更難預測,突發性也將更明顯。所以云計算數據中心的網絡必須選用專門的數據中心級交換機來架構。與傳統的城域網交換機相比,數據中心交換機有幾個突出優點,從而能滿足云計算數據中心這種嚴酷的環境。

(1)完全無阻塞交換網:數據中心級交換機采用CLOS交換網,這是一種完全無阻塞交換架構,從而保證在任何流量特征的環境下,交換網都是可以實現無阻塞交換。

(2)分布式大緩存:云計算環境下,機機交互的頻率大大增加,從而使得瞬間多端口向一端口轉發的機率也大大增加,流量的突發性非常嚴重。傳統的城域網交換機一般僅在出端口方向裝配有很小的緩存,通常每板只有32-64M,緩存時間只有10-20mS左右。遇到多端口向單一端口轉發流量時,一個端口本來就很小的緩存還要應對多端口的流量沖擊,迅速就發生緩存擁塞丟包。而丟包后,將會引起應用層的重傳,從而進一步導致更嚴重的網絡擁塞。數據中心級交換機采用入端口分布式大緩存的革新架構,其平均每個10G端口的入緩存可達256M,GE端口的緩存達20M,從而保證在任何流量模型情況下,端口緩存時間最大均可達到200mS以上,為云計算的應用提供了一個扎實的網絡基礎。

隨著越來越多的終端設備接入網絡,網絡IPv4地址已將消耗殆盡,從IPv4向IPv6的全面演進已迫在眉睫。作為新一代數據中心網絡,支持IPv4/IPv6的雙棧接入也是必然的要求,并且要求對IPv4/IPv6均要能提供線速的轉發能力,高性能、靈活地實現兩個網絡互訪。

綠色節能

數據中心已經成為耗能大戶,如何才能建設一個綠色節能的數據中心已經成為關注的重點。數據中心的節能是一個系統工程,IT設備功耗占總體能耗的31%左右,而空調、冷風機等的能耗占了40%左右。所以不僅IT設備本身的功耗,而且IT設備對空調、冷風機的功耗影響也是需要關注的重點。

根據TIA-942標準及業內實踐來看,采用下送風專用機柜,背對背方式排列,冷風在機柜底部前邊進風,進入數據設備后熱風在數據機柜后側排出,與上送風形式相比空調風機耗電量節省30%。所以綠色數據中心設備都要求是豎插槽,后端下進風,上端前出風的設備,以滿足數據中心整體布局要要求。

艾銻無限科技專業:IT外包、企業外包、北京IT外包、桌面運維、弱電工程、網站開發、wifi覆蓋方案,網絡外包,網絡管理服務,網管外包,綜合布線,服務器運維服務,中小企業it外包服務,服務器維保公司,硬件運維,網站運維服務

以上文章由北京艾銻無限科技發展有限公司整理

相關文章

關閉

關閉